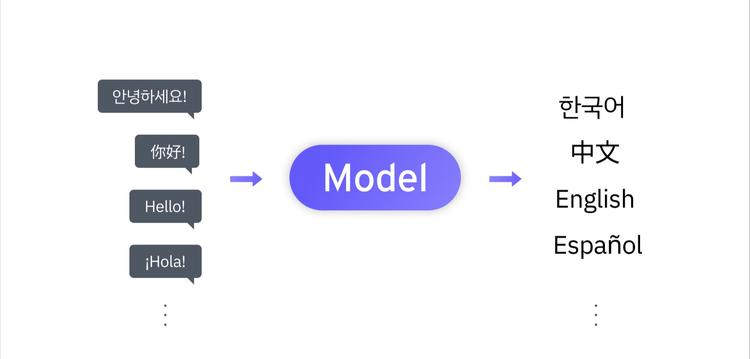

42dot에서는 지난 가을, 자체 개발한 초거대 언어 모델인 42dot LLM을 공개한 바 있습니다. 42dot LLM은 국내 최초의 한영 통합 언어 모델로서 직접 구축한 데이터와 자체 학습 인프라를 활용해, 비슷한 규모의 다른 언어 모델 대비 월등한 성능을 달성하며 좋은 품질을 보여줬습니다. LLM은 크게 사전 학습 모델인 PLM과 사용자 지침을 따르도록 튜닝한 파인 튜닝 모델로 구분할 수 있습니다. 저희는 두 모델을 모두 공개하였으며, 전자는 42dot LLM-PLM이라는 이름으로, 후자는 42dot LLM-SFT라는 이름으로 공개한 바 있습니다.

[42dot LLM 실행 데모]

1. SFT 모델

미세 조정 모델 중에서도 정교하게 레이블을 지정한 소규모 데이터셋을 이용해 사전 학습 모델의 가중치와 편향을 조정하는 기법을 Supervised Fine-Tuning이라 하는데, 이 기법을 활용한 언어 모델을 해당 기법의 영어 약어를 덧붙여 SFT 모델이라 부릅니다. 저희가 공개한 생성 언어 모델 또한 SFT 기법을 활용했기 때문에 특별히 42dot LLM-SFT라 명명하였으며, 우리가 흔히 챗GPT처럼 대화를 주고받을 수 있는 LLM을 이야기할 때는 바로 이 SFT 기법을 활용한 모델을 일컫습니다.

2. 라마(LLaMA) 구조

.png)

42dot LLM은 여타 LLM과 동일하게 트랜스포머의 디코더 구조를 사용하며, 특히 페이스북에서 오픈소스로 공개하여 큰 호응을 얻은 바 있는 라마(LLaMA)와 거의 동일한 구조를 채택하였습니다. 굳이 라마를 택한 이유는 다양한 프레임워크와의 호환성을 유지하기 위해 오랜 기간 심사숙고하여 내린 결정이며, 그 덕분에 한글을 전혀 이해하지 못하는 라마와 달리 저희 모델은 한글을 자연스럽게 이해하면서 해외 유명 프레임워크에서도 아무런 문제 없이 자연스럽게 구동됩니다. 물론 구조만 동일할 뿐 라마 모델의 원래 매개변수는 전혀 사용하지 않았기 때문에 모든 매개변수는 바닥부터 저희가 직접 학습을 진행하였습니다.

3. 모델 크기

42dot LLM은 13억 개가 넘는 매개변수를 지닌 1.3B 모델이며, 총 24개의 레이어를 갖고 있는 초거대 언어 모델입니다. 여기에 라마와 거의 동일한 분량인 1.4조(1.4T) 개의 토큰을 이용해 학습을 진행하였으며, 해외의 여타 LLM과 달리 대량의 고품질 한글 데이터를 포함하여, 한글과 영어를 동시에 이해하는 한영 통합 언어 모델을 구축하였습니다.

4. 토크나이저

.png)

문장을 단어 또는 음절 같이 최소 단위로 나누는 작업을 토큰화(Tokenization) 작업이라고 하며 이 작업을 하는 도구를 토크나이저(Tokenizer)로 부릅니다. 이 중 글자를 바이트 단위로 쪼개어, 자주 등장하는 바이트의 쌍을 쌓아나가는 방식을 Byte-Pair Encoding, 줄여서 BPE 알고리즘이라 하는데 이 방식은 한글에도 매우 유리합니다. 왜냐면 우리말은 교착어이기 때문에 다양한 표현이 가능하여 분석하기 어렵지만 BPE는 이런 다양한 변형을 잘 파악할 수 있기 때문이죠. 이 때문에 오픈 AI의 GPT도 같은 방식을 사용한 바 있으며, 저희 42dot LLM 또한 BPE 방식을 사용해 문장을 토큰화하고 있습니다. 이렇게 토큰화 과정을 거쳐 한글과 영어 토큰 약 5만여 개로 구성된 단어 사전을 구축하였으며 이 과정은 총 1천만 건의 문서를 샘플링하여 구축하였습니다.

5. GPU 학습 클러스터

42dot은 320장의 GPU를 동시에 투입할 수 있는 고성능의 GPU 학습 클러스터를 자체 구축하여 보유하고 있습니다. 42dot LLM-PLM의 학습 또한 이 인프라를 활용하였으며 A100 80G GPU로 총 49,152 시간(GPU hours) 동안 학습을 진행하였습니다. 320장을 동시에 투입할 경우 약 1주일 남짓 소요되는 시간이며, 여기에 더해 42dot LLM-SFT에 112 시간(GPU hours)을 추가로 학습하였습니다.

6. 성능 평가 결과

.png)

이렇게 완성된 42dot LLM은 제로샷 성능 평가에서 비슷한 규모의 다른 언어 모델 대비 월등한 성능을 달성하였습니다. 한국어뿐만 아니라 영어에서도 높은 성능을 보였으며 10가지 카테고리에 대해 총 121개의 프롬프트로 구성한 대화 성능 평가에서도 비슷한 규모의 다른 언어 모델에 대비해서 압도적인 성능 차이를 보입니다. 심지어 GPT-3.5와도 크게 차이 나지 않는 놀라운 품질을 보여줍니다.

7. 모델 무료 공개

각 모델 파일은 모두 무료로 공개하였습니다. 또한 간단한 생성 코드를 함께 제공하여 누구나 손쉽게 LLM을 구동할 수 있도록 하였습니다. 라이선스는 CC BY-NC 4.0를 따르며 출처를 밝히면 비상업적 용도에 한 해 누구나 자유롭게 활용하실 수 있습니다.

저희는 오픈소스 생태계의 힘을 믿습니다.

여타 LLM과 마찬가지로 42dot LLM도 환각(Hallucination) 현상 같은 근본적인 문제를 지니고 있으며, 미처 포함하지 못한 질문-응답 케이스가 존재할 수 있기 때문에 기대하는 형태의 응답을 생성하지 못할 수도 있습니다. 하지만 혁신을 촉발하는 오픈소스의 힘은 이 같은 문제 또한 근시일 내에 해결해 내리라 믿습니다.

42dot의 국내 최초 한영통합 언어 모델 공개로 우리나라의 LLM 생태계가 한 단계 더 도약하길 기대해 봅니다.

LLM Group

새로운 유형의 모빌리티 경험을 제공하기 위한 large language model을 개발하고 있습니다.

.png&w=750&q=75)

.png&w=750&q=75)

.png&w=750&q=75)

.jpg&w=750&q=75)

.png&w=750&q=75)

.png&w=750&q=75)

.png&w=750&q=75)