Natural Language

Processing

Processing

Model Description

Hyperparameters

42dot LLM-SFT는 42dot LLM-PLM과 동일하게 LLaMA 2 아키텍처로 구성되었으며, 모델 하이퍼파라미터는 다음과 같습니다.

| Params | Layers | Attention heads | Hidden size | FFN size | Max. length* |

|---|---|---|---|---|---|

| 1.3B | 24 | 32 | 2,048 | 5,632 | 4,096 |

(* unit: tokens)

Supervised Fine-tuning

미세 조정은 약 112 GPU hours가 소요되었습니다(NVIDIA A100 사용). 학습 데이터는 자체 구축하였으며 <질문 혹은 지시> 및 <응답> 쌍으로 구성되어 있습니다. 또한 학습 데이터는 싱글턴 및 멀티턴으로 구축하였습니다.

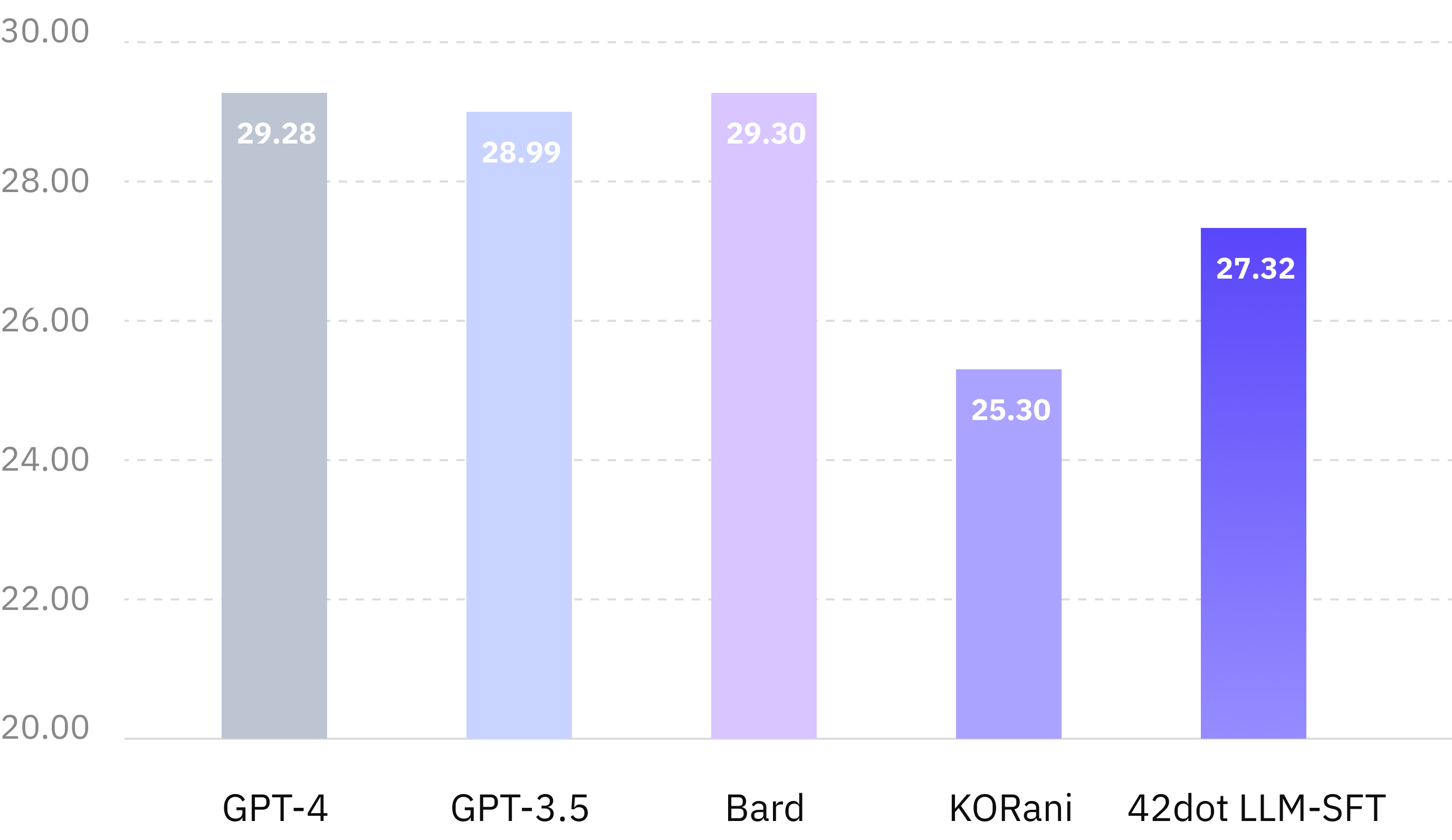

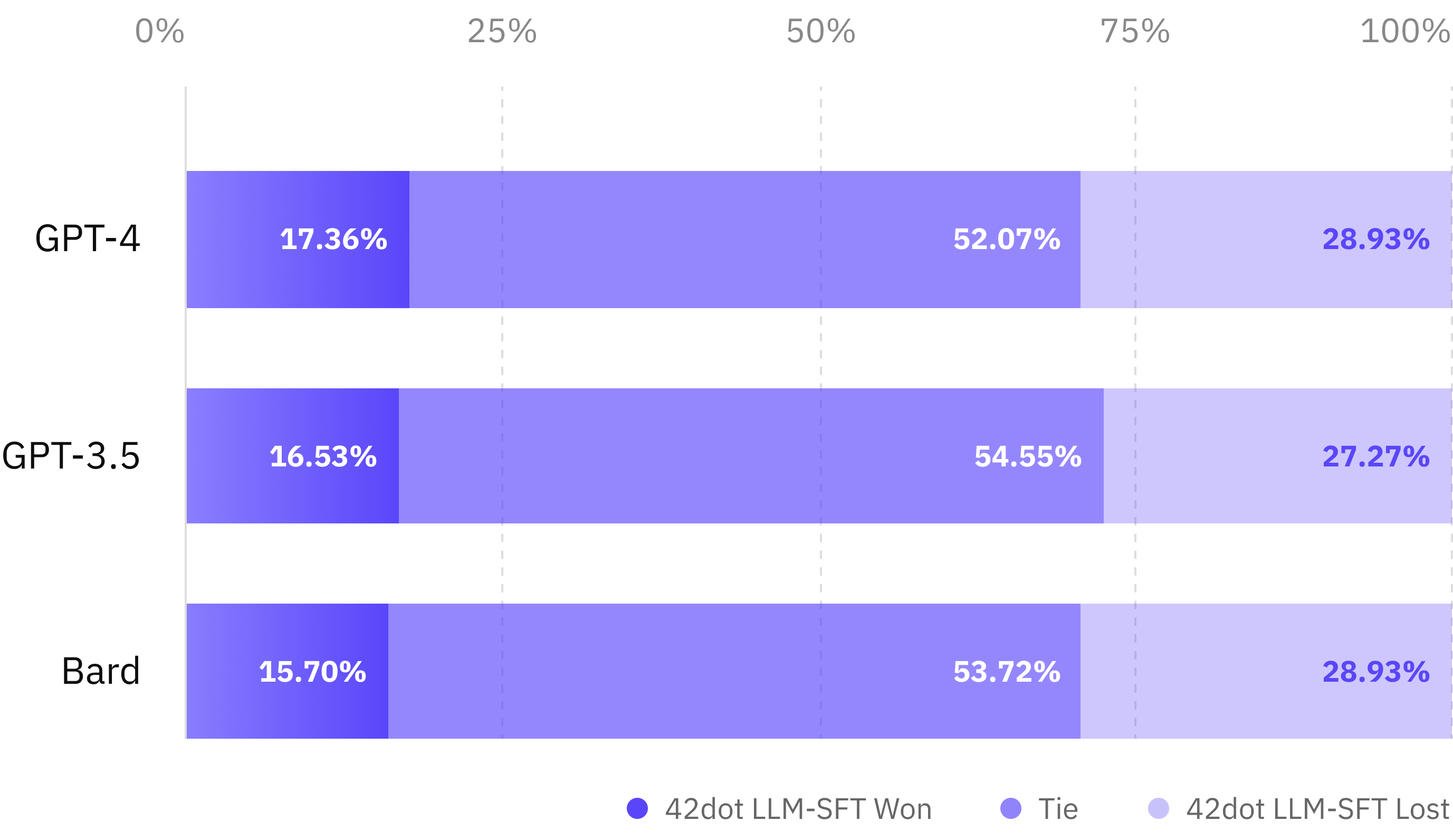

Baselines

- ChatGPT using GPT-3.5-turbo and GPT-4

- Bard

- KORani-v2-13B

| Model | GPT-3.5 | GPT-4 | Bard | KORani | 42dot LLM-SFT |

|---|---|---|---|---|---|

| Params | Unknown | Unknown | Unknown | 13B | 1.3B |