Natural Language

Processing

Processing

| Params | Layers | Attention heads | Hidden size | FFN size |

|---|---|---|---|---|

| 1.3B | 24 | 32 | 2,048 | 5,632 |

Pre-training

사전학습은 약 49,152 GPU hours가 소요되었습니다(NVIDIA A100 사용). 다음과 같은 세팅을 적용하여 학습하였습니다.

| Params | Global batch size* | Initial Learning rate | Train iter.* | Max length | Weight decay |

|---|---|---|---|---|---|

| 1.3B | 4.0M | 4E-4 | 1.4T | 4,096 | 0.1 |

(* unit: tokens)

Tokenizer

자체 학습한 Byte-level BPE 토크나이저를 사용하였습니다. 한국어와 영어 데이터에서 각각 1000만 개의 문서를 샘플링하여 vocabulary를 학습했으며 vocabulary 크기는 약 5만 개입니다.

Zero-shot evaluations

42dot LLM-PLM의 성능을 한국어와 영어 Zero-shot 벤치마크 데이터로 평가하였습니다. 아래 결과는 lm-eval-harness와 huggingface 허브에 공개된 모델들을 사용하여 도출하였습니다.

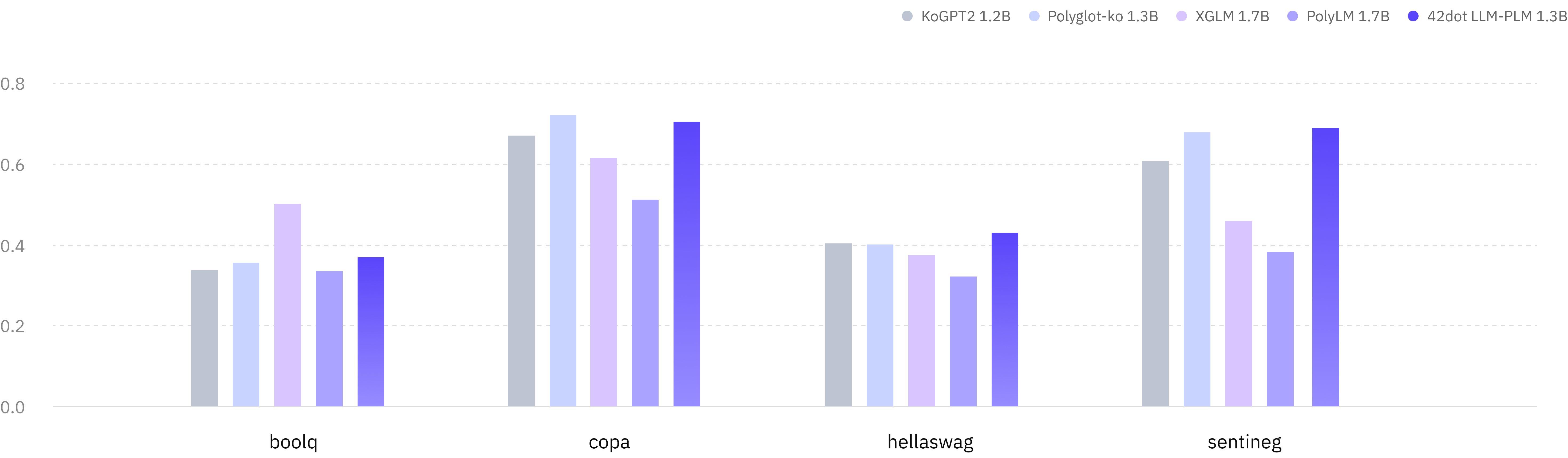

Korean (KOBEST)

| Tasks / Macro-F1 | KoGPT2 1.2B | Polyglot-Ko 1.3B | XGLM 1.7B | PolyLM 1.7B | 42dot LLM-PLM 1.3B |

|---|---|---|---|---|---|

| boolq | 0.337 | 0.355 | 0.502 | 0.334 | 0.369 |

| copa | 0.67 | 0.721 | 0.616 | 0.513 | 0.704 |

| hellaswag | 0.404 | 0.401 | 0.374 | 0.321 | 0.431 |

| sentineg | 0.606 | 0.679 | 0.46 | 0.382 | 0.69 |

| average | 0.504 | 0.539 | 0.488 | 0.388 | 0.549 |

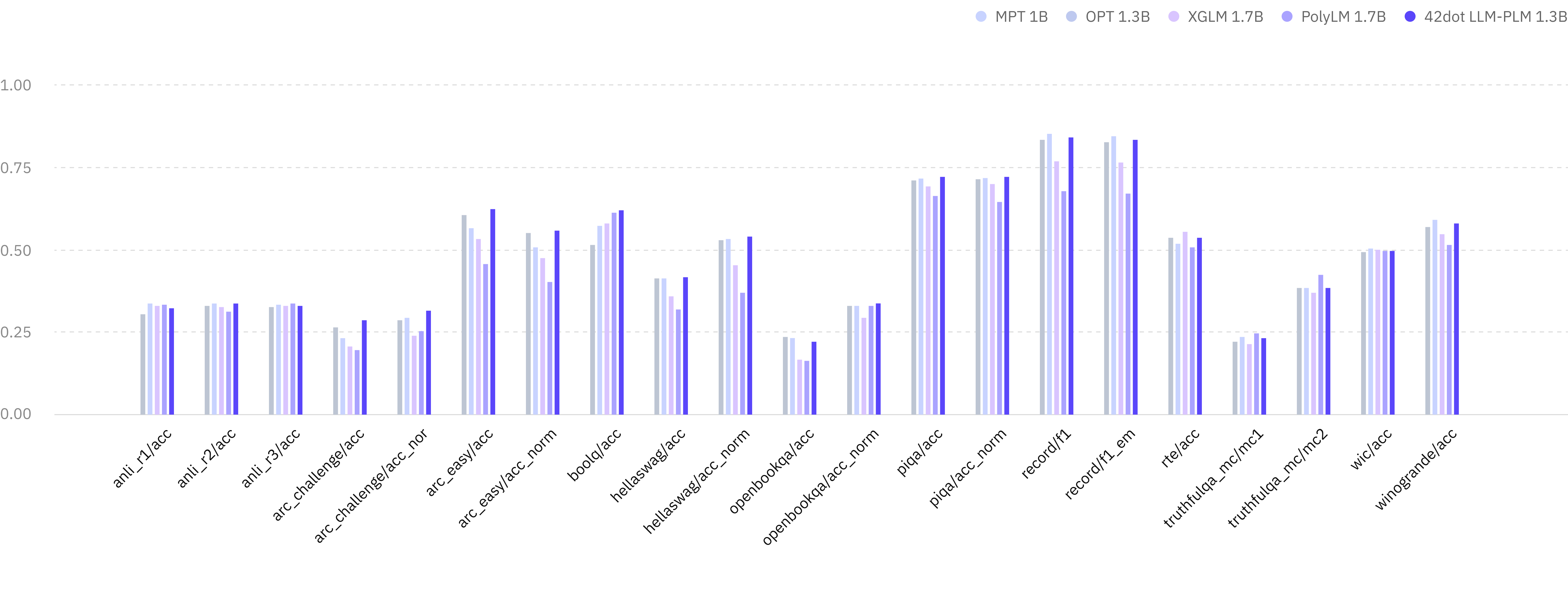

English

| Tasks / Macro-F1 | MPT 1B | OPT 1.3B | XGLM 1.7B | PolyLM 1.7B | 42dot LLM-PLM 1.3B |

|---|---|---|---|---|---|

| anli_r1/acc | 0.309 | 0.341 | 0.3342 | 0.336 | 0.325 |

| anli_r2/acc | 0.334 | 0.339 | 0.331 | 0.314 | 0.34 |

| anli_r3/acc | 0.33 | 0.336 | 0.333 | 0.339 | 0.333 |

| arc_challenge/acc | 0.268 | 0.234 | 0.21 | 0.198 | 0.288 |

| arc_challenge/acc_norm | 0.291 | 0.295 | 0.243 | 0.256 | 0.317 |

| boolq/acc | 0.517 | 0.578 | 0.585 | 0.617 | 0.624 |

| hellaswag/acc | 0.415 | 0.415 | 0.362 | 0.322 | 0.422 |

| hellaswag/acc_norm | 0.532 | 0.537 | 0.458 | 0.372 | 0.544 |

| openbookqa/acc | 0.238 | 0.234 | 0.17 | 0.166 | 0.222 |

| openbookqa/acc_norm | 0.334 | 0.334 | 0.298 | 0.334 | 0.34 |

| piqa/acc | 0.714 | 0.718 | 0.697 | 0.667 | 0.725 |

| piqa/acc_norm | 0.72 | 0.724 | 0.703 | 0.649 | 0.727 |

| record/f1 | 0.84 | 0.857 | 0.775 | 0.681 | 0.848 |

| record/em | 0.832 | 0.849 | 0.769 | 0.674 | 0.839 |

| rte/acc | 0.541 | 0.523 | 0.559 | 0.513 | 0.542 |

| truthfulqa_mc/mc1 | 0.224 | 0.237 | 0.215 | 0.251 | 0.236 |

| truthfulqa_mc/mc2 | 0.387 | 0.386 | 0.373 | 0.428 | 0.387 |

| wic/acc | 0.498 | 0.509 | 0.503 | 0.5 | 0.502 |

| winogrande/acc | 0.574 | 0.595 | 0.55 | 0.519 | 0.583 |

| average | 0.479 | 0.482 | 0.452 | 0.429 | 0.492 |